Hello

I am Seonho Lee (Griffin Sunho Lee in the US). I will be working as an Applied AI Research Scientist at Krafton AI starting in 2026. I got a M.S. degree from KAIST AI in Artificial Intelligence and had worked as an AI graduate researcher at the Computer Vision and Machine Learning Lab at KAIST, under the supervision of Prof. Hyunjung Shim.

I am interested in research on AI especially in Computer vision. I hope to use AI to help people freely envision, realize, and share what they believe in.

Particularly, I am researching on the following topics:

1. Generative AI

2. Vision-Language Understanding

CV

E-mail

Github

LinkedIn

Google Scholar

- Email: glanceyes (at) kaist (dot) com

News

Oct. 2025: Two papers PartCATSeg and 3D-Aware VLM Finetuning got selected as QIFK(Qualcomm Innovation Fellowship Korea) 2025 Finalist.

Aug. 2025: Our 3D-Aware VLM Finetuning paper got accepted to EMNLP 2025 Findings!

Jun. 2025: I got ML engineering internship at Snap Inc. in Santa Monica, CA.

Jun. 2025: I got awarded Korean Presidential Science Scholarship for Graduate Students.

May. 2025: Our ScribbleDiff paper got accepted to ICIP 2025!

Feb. 2025: Our PartCATSeg paper got accepted to CVPR 2025!

Jan. 2025: Our DreamCatalyst paper got accepted to ICLR 2025!

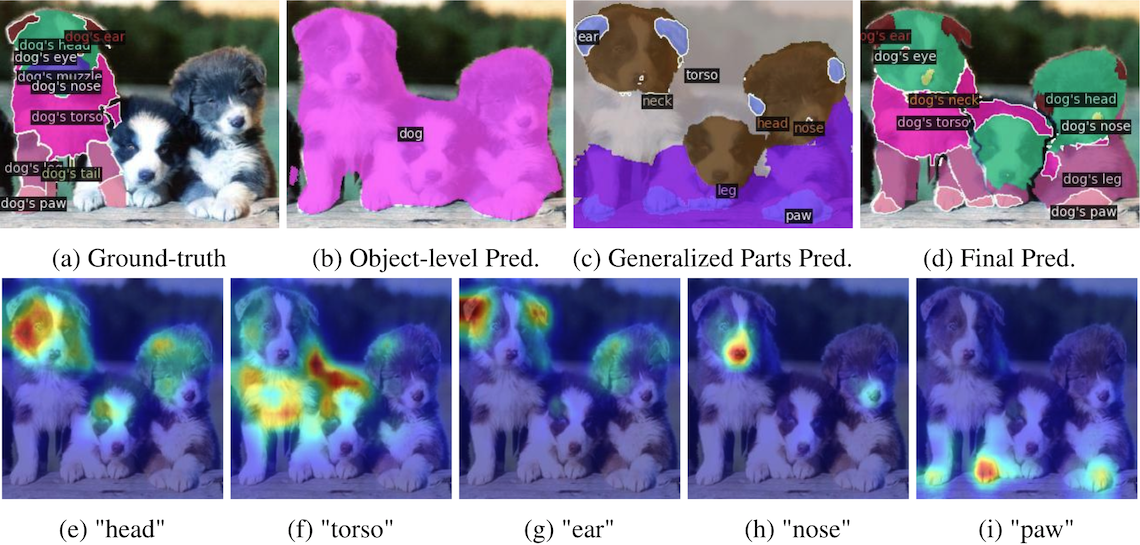

Sep. 2024: Our PartCLIPSeg paper got accepted to NeurIPS 2024!

Sep. 2023: I got accepted to CVML Lab as a M.S. graduate student in KAIST AI.

Publications

*: equal contribution. †: corresponding author. C: conference P: preprint

[C5] 3D-Aware Vision-Language Models Fine-Tuning with Geometric Distillation

- Seonho Lee*, Jiho Choi*, Inha Kang, Jiwook Kim, Junsung Park, Hyunjung Shim†

- Keywords: 3D-Aware VLM Finetuning

EMNLP 2025 Findings, Paper, Codes

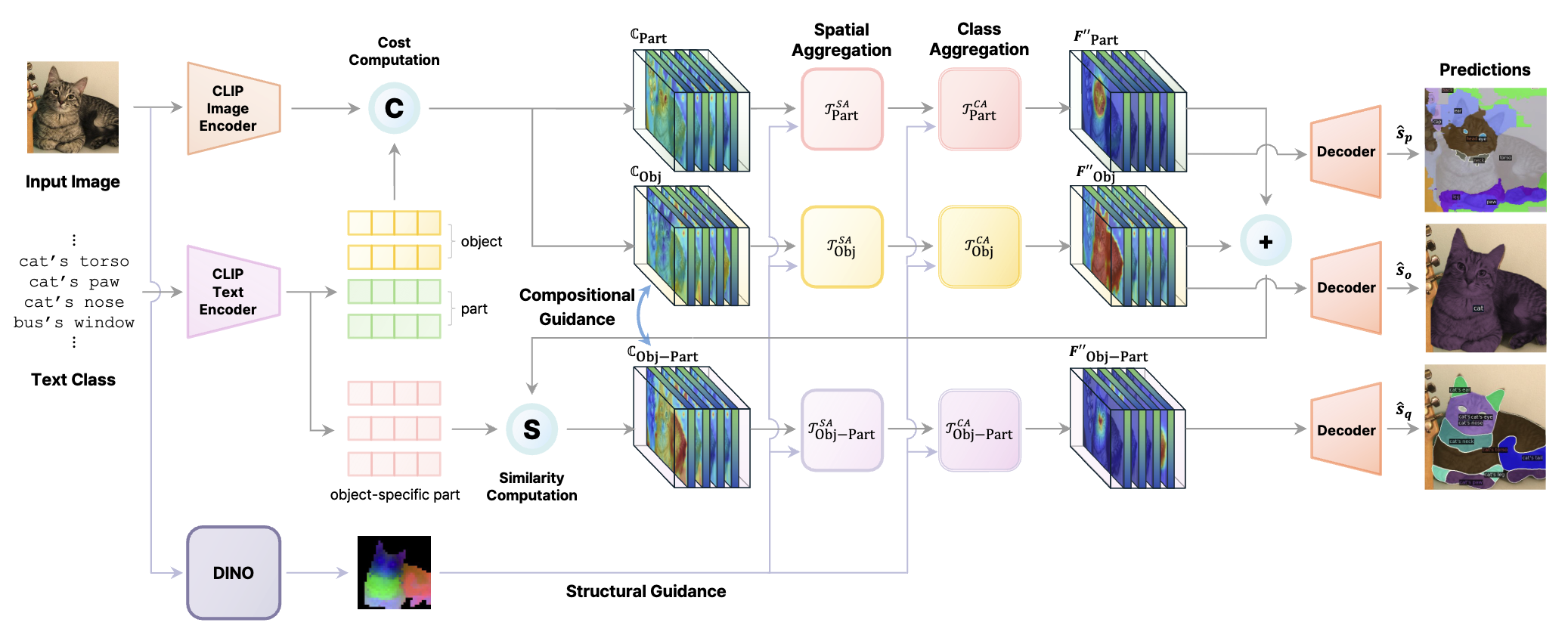

[C4] Fine-Grained Image-Text Correspondence with Cost Aggregation for Open-Vocabulary Part Segmentation

- Jiho Choi*, Seonho Lee*, Seungho Lee, Minhyun Lee, Hyunjung Shim†

- Keywords: Open-Vocabulary Part Segmentation

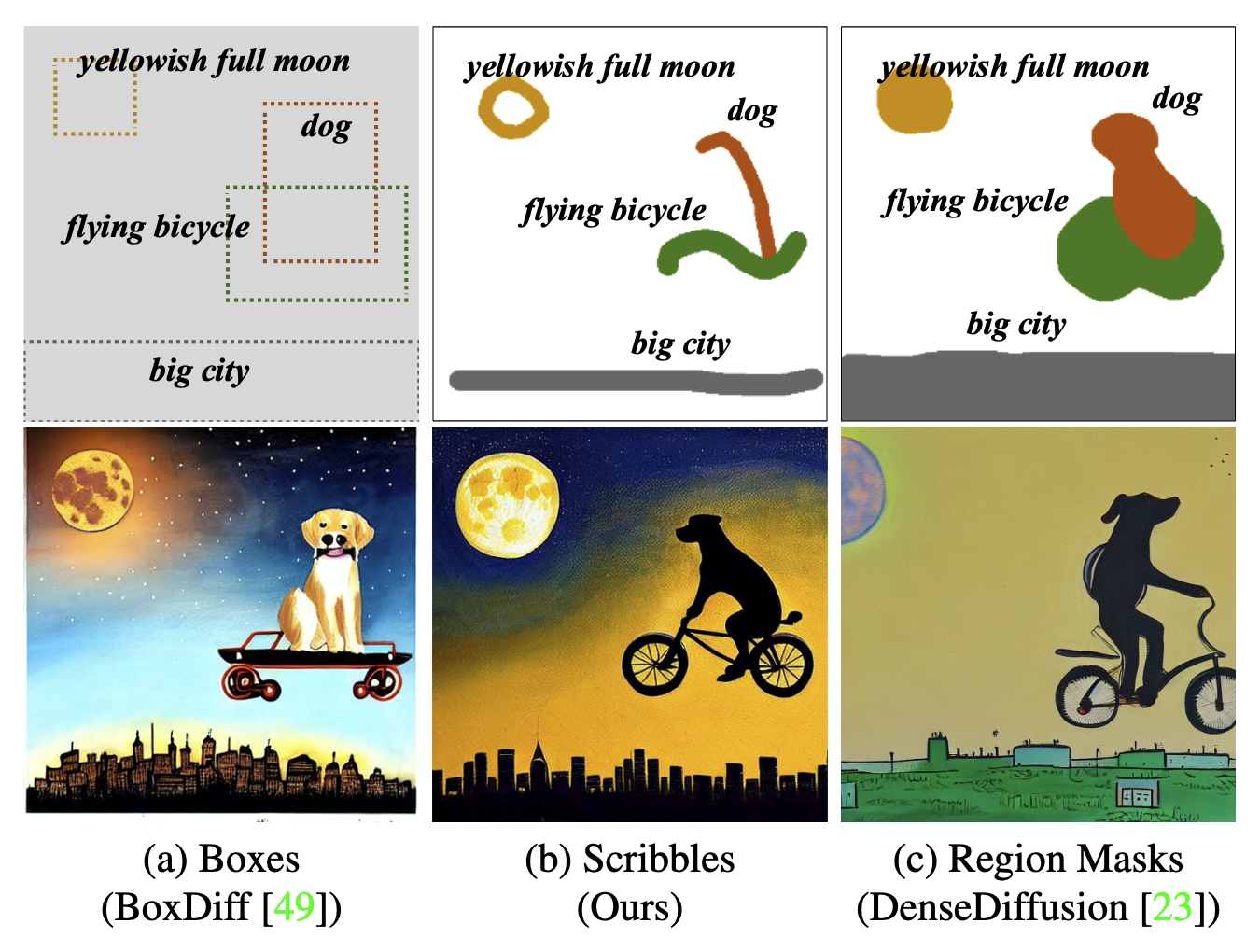

[C3] Scribble-Guided Diffusion for Training-free Text-to-Image Generation

- Seonho Lee*, Jiho Choi*, Seohyun Lim, Jiwook Kim, Hyunjung Shim†

- Keywords: Conditional Image Generation

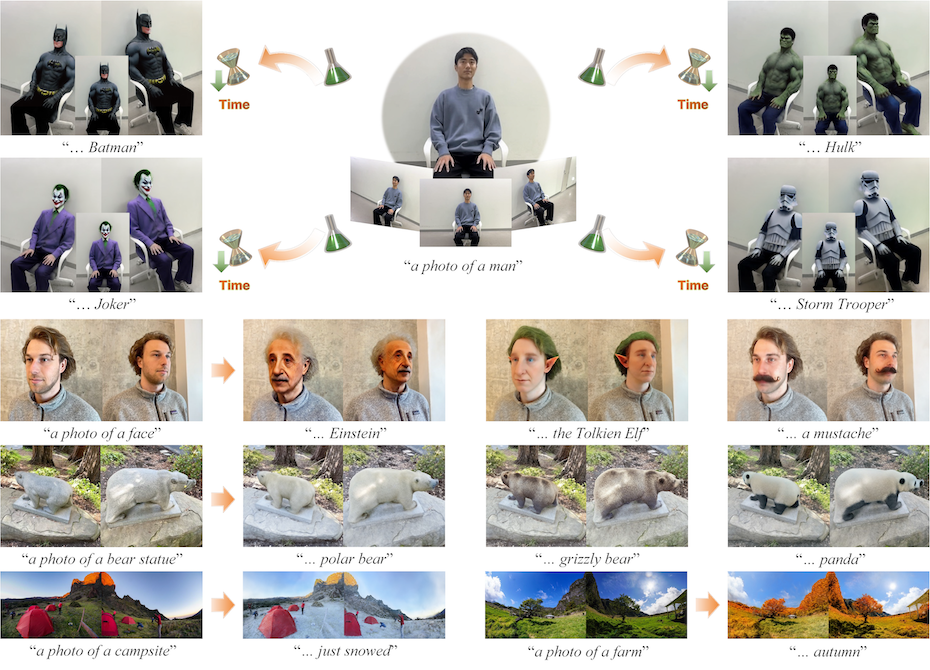

[C2] DreamCatalyst: Fast and High-Quality 3D Editing via Controlling Editability and Identity Preservation

- Jiwook Kim*, Seonho Lee*, Jaeyo Shin, Jiho Choi, Hyunjung Shim†

- Keywords: 3D Editing, Score Distillation

ICLR 2025, Paper, Project Page, Codes

[C1] Understanding Multi-Granularity for Open-Vocabulary Part Segmentation

- Jiho Choi*, Seonho Lee*, Seungho Lee, Minhyun Lee, Hyunjung Shim†

- Keywords: Open-Vocabulary Part Segmentation

[P3] Mitigating Perceptual Judgment Bias in Multimodal LLM-as-a-Judge via Perceptual Perturbation and Reward Modeling

- Seojeong Park*, Jiho Choi*, Junyong Kang, Seonho Lee, Jaeyo Shin, Hyunjung Shim†

- Keywords: Multimodal LLM, Perceptual Judgment Bias

Under Review

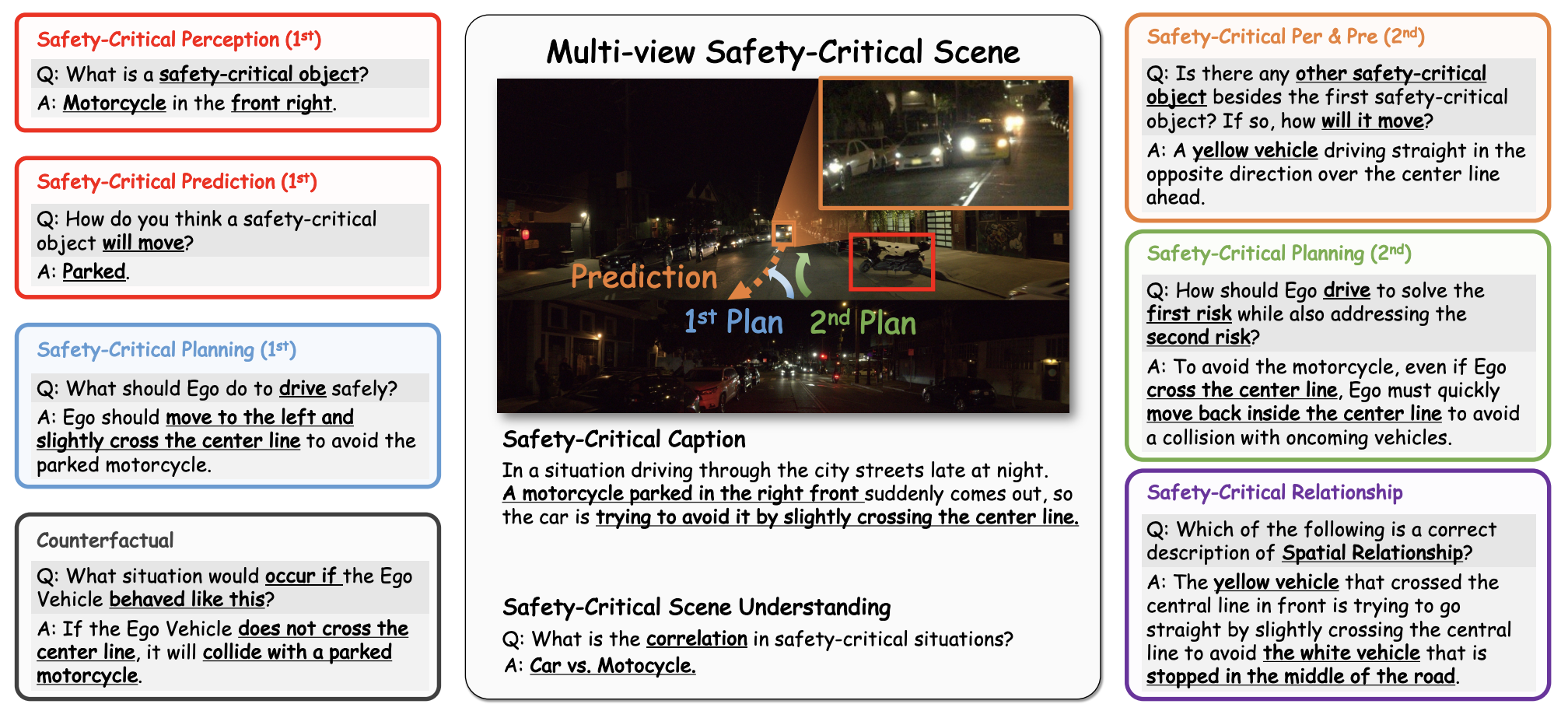

[P2] WaymoQA: A Multi-View Visual Question Answering Dataset for Safety-Critical Reasoning in Autonomous Driving

- Seungjun Yu, Seonho Lee, Namho Kim, Jaeyo Shin, Junsung Park, Wonjeong Ryu, Raehyuk Jung, Hyunjung Shim†

- Keywords: Visual Question Answering, Safety-Critical Reasoning

[P1] What “Not” to Detect: Improving Object Detection under Negation via Reasoning and Token Merging

- Inha Kang, Youngsun Lim, Seonho Lee, Jiho Choi, Junsuk Choi†, Hyunjung Shim†

- Keywords: Described Object Detction under Negation

Work Experience

Snap Inc.

- ML engineer intern at Generative ML team (VideoCraft)

- Jun. 2025 ~ Sep. 2025, Santa Monica, CA, USA (On-site)

- Led a project for establishing cross-reference dataset preprocessing pipeline for personalized video generation

- Developed new model architecture with multi-subject adapters for VideoAlchemist 2.0

Projects

3D-Aware VLM Finetuning, Samsung Research

- Electronic Device and Method for Operating Thereof and Storage Medium

- Korean patent: 10-2025-0109574

SHrack: Mobile Web Service for Real-time Exercise Count Tracking

- Web-based real-time video streaming service for accurate exercise count detection

- Keywords: MobileNet, Contextual Prediction Module

RECJOON: Backjoon Online Judge Problem Solving Recommendation System

- Naver Boostcamp AI Tech 3rd (Mar. 2022 ~ Jun. 2022)

- Keywords: Recommendation System

KUVIS: Web-based Visual Programming Software with Deep Learning in Medicine

- Seonho Lee, Yoomin Kang, Advised by Prof. Wonki Jeong (Jul. 2022 ~ Aug. 2022)

- Keywords: Visual Programming, Parallel Computing for Deep Learning

- Prototype of VIENCE Pathoview

Education

KAIST

- M.S. in Artificial Intelligence, Mar. 2024 ~ Feb. 2026 (Expected)

- GPA: 4.20 / 4.3

Sogang University

- B.S. in Computer Science and Engineering, Mar. 2017 ~ Feb. 2024 (Expected)

- GPA: 4.12 / 4.3 (Summa Cum Laude)

Sangsan High School

Honors and Awards

Qualcomm Innovation Fellowship Korea (QIFK) 2025 Finalist

- Selected as a finalist by Qualcomm AI Research (Oct. 2025)

- Two papers: PartCATSeg and 3D-Aware VLM Finetuning

Korean Presidential Science Scholarship for Graduate Students

- Awarded by the President of Korea (Jun. 2025)

2nd Place on Open Vocabulary Part Segmentation Challenge at CVPR 2024

- 2nd Place Winnder both on Track 1 and 2

- 4th workshop on Open World Vision at CVPR 2024

Excellence Award in 2023 POSTECH OIBC Challenge

- 3rd Place (3/120) in AI Competition of Solar Power Generation Forecasting (Dec. 2023)

2022 ICPC Asia Korea Regional Contest

- 48th in Korea, 62nd in Preliminary

Korea National Science and Technology Scholarship

- Spring 2019, Fall 2022, Spring 2023, Fall 2023 (4 Semesters)

Dean’s List, Sogang University

- 1%: Spring 2018, Spring 2019, Fall 2022

- 5%: Fall 2018

Academic Activities

Reviewer

- 3DV 2026

Last updated: 4th, Jan. 2026